一、出台背景

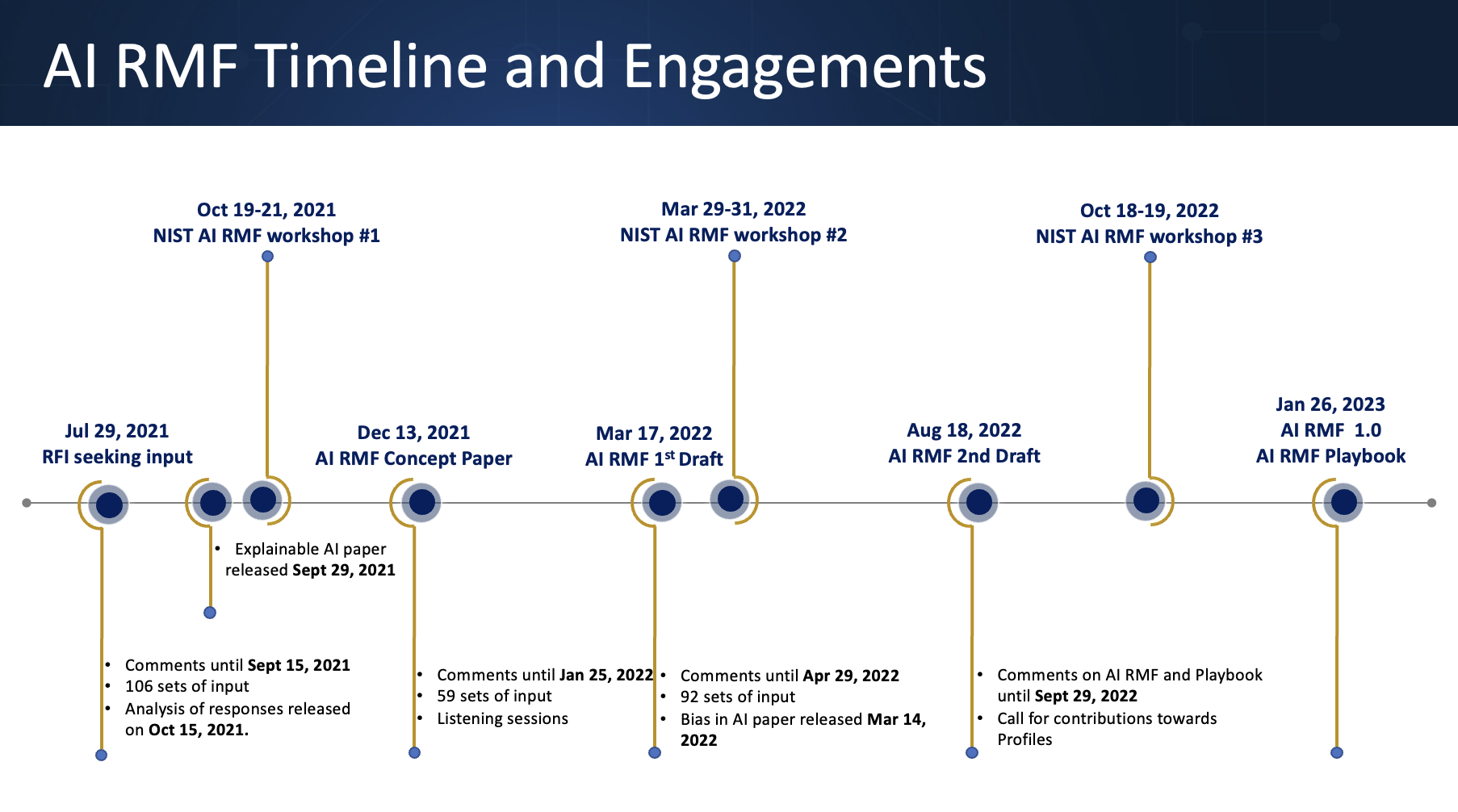

美国尚未出台全国统一的人工智能专门法律,治理体系主要依托现有法律、总统行政命令、行业指南及技术标准。其中具有代表性的文件包括《安全、可靠、可信AI开发与使用行政命令》(2023年)、NIST《人工智能风险管理框架》(AI RMF)等。

二、治理原则

强调以风险为导向、促进创新、保持灵活性,结合行业自律与政府监管共同推动人工智能安全可控发展。

三、主要内容

- 国家安全与关键基础设施:白宫制定国家安全与情报机构AI应用准则,禁止大规模监控、自动武器等高风险用途;国土安全部发布关键基础设施AI部署责任框架,要求安全设计、偏见检测、独立评估和透明度。

- 技术标准与风险管理:NIST发布AI RMF,提供可信AI风险管理指南,鼓励企业和机构采用。

- 机构与政策支持:成立人工智能标准与创新中心(CAISI),聚焦网络安全、生物安全等领域;发布《AI行动计划》,提出放宽监管、加大基础设施投资、加速AI部署。

- 执行方式:以现有行业法规为基础,结合行政命令、技术标准、监管沙盒和行业指南构成分散式治理体系。

四、特点与意义

美国采取分布式、行业化监管模式,灵活适应技术快速发展,同时与国家安全战略和经济竞争力目标紧密结合。

详见官网: