1. 背景

米国はまだ統一された国家人工知能法を発行しておらず、統治システムは主に既存の法律、大統領令、業界ガイドライン、技術基準に依存しています。 代表的な文書には、安全で信頼性が高く信頼できる AI の開発と使用に関する大統領令 (2023 年) や NIST の人工知能リスク管理フレームワーク (AI RMF) が含まれます。

2. ガバナンスの原則

リスク志向を重視し、イノベーションを促進し、柔軟性を維持し、業界の自律と政府の監督を組み合わせて、人工知能の安全で制御可能な開発を共同で推進します。

3. 主な内容

- 国家安全保障と重要インフラ: ホワイトハウスは、国家安全保障機関および諜報機関における AI の適用に関するガイドラインを策定し、大規模な監視や自動小銃などのリスクの高い使用を禁止します。 国土安全保障省は、重要なインフラにおける AI 導入に対する説明責任の枠組みを発表し、安全な設計、バイアス検出、独立した評価、透明性を要求しています。

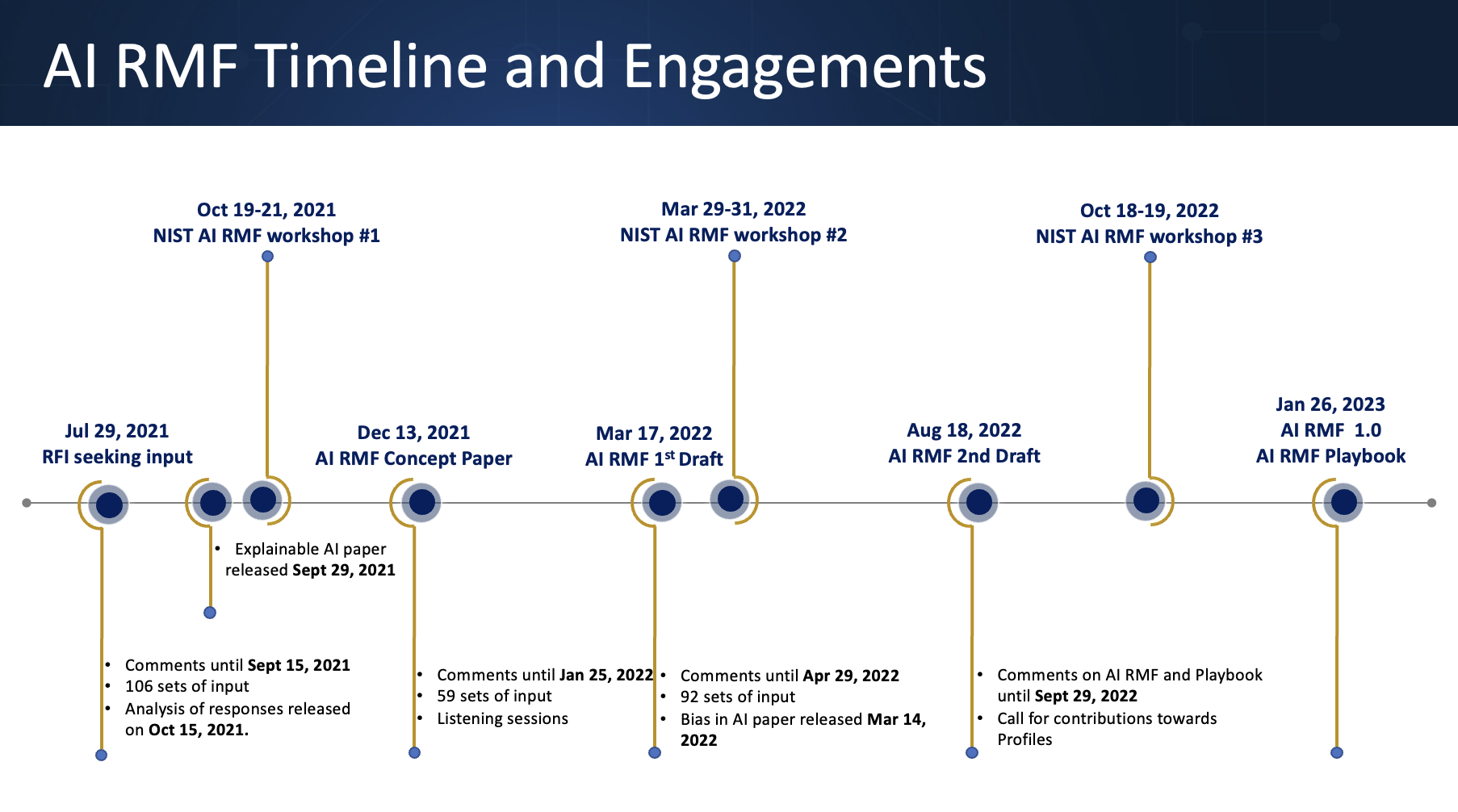

- 技術基準とリスク管理: NIST は AI RMF をリリースし、企業や機関による導入を促進するための信頼できる AI リスク管理ガイドを提供しています。

- 制度的および政策的支援: サイバーセキュリティ、バイオセキュリティ、その他の分野に焦点を当てた人工知能標準イノベーションセンター (CAISI) を設立する。 「AI行動計画」が発行され、規制の緩和、インフラ投資の増加、AIの導入の加速が提案されました。

- 実施方法:既存の業界規制に基づいて、行政命令、技術基準、規制サンドボックス、業界ガイドラインと組み合わせて、分散型ガバナンスシステムが形成されます。

4. 特徴と意義米国

は、テクノロジーの急速な発展に柔軟に適応し、国家安全保障戦略や経済競争力の目標と密接に統合するために、分散型で工業化された規制モデルを採用しています。

詳細については、公式ウェブサイトを参照してください: